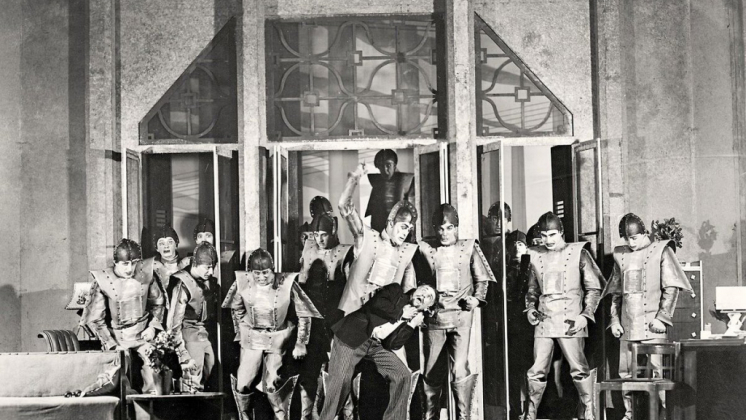

El 25 de enero del 2021 se cumplen cien años de la publicación del libro Rossum Universal Robots escrito por el autor checo de ciencia ficción Karel Čapek. Es muy probable que el libro de Čapek se encontrara muy influenciado por la novela El Golem de Gustav Meyrink, publicada en 1915. Sin embargo, existen diferencias significativas entre las dos obras. Meyrink escribió su novela basándose en el folclore judío de su ciudad natal (el cementerio judío de Praga todavía alberga la tumba del rabino Lev quien, según dice la leyenda, creó un golem) y en esa novela solo existe un único ser que es creado por el ser humano y que termina por salirse de control. Čapek, por el contrario, crea millones de ellos y existen diferentes versiones de sus robots: los modelos más inteligentes sustituyen a los modelos más antiguos.

Esta pequeña obra anticipó con mucho obras posteriores que abordarían ese mismo tema, además de inspirar a muchas películas del género cyberpunk y postapocalíptico como The Terminator y Alien: Covenant. Los robots de la compañía de Rossum fueron concebidos como ayudantes que asistían a los seres humanos en sus trabajos, pero después de un tiempo terminaron por rebelarse y destruyeron a toda la humanidad, con la excepción de un empleado de la fábrica de Rossum que ellos necesitaban para crear a más individuos de su propia especie.

El

mismo término «robot» pronto se convirtió en algo

omnipresente y comenzó a aplicarse a toda clase de máquinas que

tuvieran un conjunto muy limitado de funciones preprogramadas y que

necesitaban ser diagnosticadas, mantenidas y reparadas por operadores

humanos. Pero recientemente, especialmente después del desarrollo de

las computadoras y las tecnologías cibernéticas, se ha comenzado a

discutir sobre el hecho de que las máquinas pueden pensar y tomar

decisiones en los mismos términos que las ideas que toman los seres

humanos.

Y en ningún otro campo los últimos logros conseguidos por la robótica y la informatización de la sociedad tienen mayor demanda que en el campo militar.

Esto se puede ver claramente en el caso de los Estados Unidos, donde se han establecido centros especiales para desarrollar programas, aplicaciones y hardware específicamente dirigidos con respecto al sector militar. Numerosos laboratorios del Ejército, de la Infantería de Marina, la Armada y la Fuerza Aérea de los EE.UU. se encuentran desarrollando, con la ayuda de contratistas e instituciones de alta tecnología del país, prototipos avanzados que son bastante prometedores y que se desarrollan hasta sus últimas conclusiones lógicas: todos estos nuevos prototipos deben estar listos para cuando Washington esté preparado para desencadenar toda una serie de nuevas guerras que se llevaran a cabo en el futuro.

Los avances recientes que se han conseguido en esta área resultar ser muy indicativos de lo que se espera conseguir.

El drone Ghost Fleet Overlord consiguió volar sin ayuda un total de 4.700 millas náuticas con mucho éxito y participó en las maniobras de Dawn Blitz. Además, funcionó de forma autónoma casi todo el tiempo (1).

Aquellos que están preocupados por el creciente poder de China sugieren usar tales sistemas en una posible guerra contra el Ejército Popular de Liberación (2). Por ejemplo, se está promoviendo el uso indiscriminado de drones submarinos suicidas que ataquen a los submarinos chinos tripulados. En los Estados Unidos se especula mucho sobre el supuesto desarrollo de submarinos y robots de combate de superficie que está desarrollando el ejército chino y a los que sus enemigos llaman “la Gran Muralla Submarina”. Por lo tanto, los militares estadounidenses proponen crear sistemas similares para estar en paridad con los chinos o de alguna manera superarlos por medio del uso de esta tecnología (3).

Los

esfuerzos chinos por crear tecnologías parecidas demuestran que el

disponer de nuevos tipos de armas no garantiza a los Estados Unidos

que dichos sistemas de armamento no sean

adoptados por otros países hostiles. Por ejemplo, la aparición de

drones de ataque creados por otras naciones ha obligado a los Estados

Unidos a desarrollar urgentemente métodos y estrategias para

contrarrestar dicho armamento.

En enero de 2021 el Departamento de Defensa de los EE.UU. formuló una estrategia para contrarrestar pequeños vehículos aéreos no tripulados, lo que demuestra la creciente preocupación que siente el ejército estadounidense por la naturaleza cambiante de la guerra y la creciente competencia armamentística que busca desafiar la supremacía de los Estados Unidos.

El teniente general Michael Groen, que es el comandante del Centro Conjunto de Inteligencia Artificial del Departamento de Defensa de los Estados Unidos, habla de la necesidad de acelerar la introducción de programas de inteligencia artificial en el campo militar (4). En su opinión, “pronto nos encontraremos en un espacio de combate definido por la toma de decisiones basada en datos, donde la acción y los ritmos de combate estén integrados. Mediante esfuerzos adecuados seremos capaces de implementar los sistemas de inteligencia artificial con los que contamos hoy y nos encontraremos operando con mayor eficiencia, lo que causará un gran impacto sin precedentes en el futuro”.

El

Centro Conjunto de Inteligencia Artificial del Pentágono, que se

creó en 2018, es ahora una de las principales instituciones

militares dedicadas a crear «objetos inteligentes» de

carácter bélico, sistemas de comunicación y de comando que serán

parte de los futuros conflictos que están por desarrollarse (5).

La inteligencia artificial es ahora el tema más discutido en los círculos científicos y militares estadounidenses. Es uno de los recursos que pueden ayudar a los Estados Unidos a lograr sus objetivos como, por ejemplo, permitir que los drones vuelen sin la supervisión de un operador, además de que sean capaces de identificar a los distintos objetivos enemigos mediante análisis rápidos y sencillos que permiten la recopilación de datos de inteligencia mediante sensores.

El desarrollo de la inteligencia artificial ha llevado a la instauración de una feroz competencia por todas partes, ya que tal tecnología se diferencia de muchas otras tecnologías del pasado debido a su tendencia natural a crear un monopolio. Esta tendencia hacia el monopolio llevará a que se exacerben las desigualdades tanto nacionales como internacionales.

La empresa PricewaterhouseCoopers predice que para 2030 el gasto del PIB mundial en el desarrollo de la inteligencia artificial podría crecer en casi 16 billones de dólares, un 70% del cual provendrá antes que nada de los Estados Unidos y China (6). Si la rivalidad por la tecnología es el curso natural de las cosas, entonces para las empresas que utilizan la inteligencia artificial como un medio con aplicaciones militares o tecnológicos, resulta bastante lógico que esta tecnología los lleve a alcanzar objetivos monopolísticos claros. Este será un nuevo tipo de carrera armamentista.

Desde el punto de vista ético, los sistemas de inteligencia artificial militar pueden participar en la toma de decisiones que permitan salvar muchas vidas o condenar a muerte a muchas personas. Los usos posibles que se pretende dar a este sistema incluyen tanto sistemas de armas autónomas letales que pueden seleccionar y atacar objetivos sin la necesidad de una intervención humana, como hacen programas de apoyo que tomen decisiones propias. Existen partidarios que proponen activamente incluir máquinas en el proceso de toma de decisiones difíciles. Por ejemplo, el científico estadounidense Ronald Arkin sostiene que tales sistemas no solo suelen tener una mayor conciencia de la situación, sino que no están motivados por la autoconservación, el miedo, la ira, la venganza o una lealtad dudosa, lo que sugiere que por razones semejantes es menos probable que los robots violen acuerdos sobre la guerra que los seres humanos…

También se cree que las funciones de la inteligencia artificial pueden transformar la relación entre los niveles táctico, operativo y estratégico de la guerra. La autonomía y la creación de redes, junto con otras tecnologías, incluidas la nanotecnología, el sigilo y la biogenética, ofrecerán sofisticadas capacidades de combate táctico en entornos como la tierra, el mar y el aire. Por ejemplo, las escuadras de robots submarinos autónomos podrían concentrarse en ubicaciones específicas en medio del océano con tal de complicar las operaciones submarinas encubiertas del enemigo, lo que actualmente proporciona una capacidad de represalia garantizada en contra de las potencias nucleares. Por lo tanto, otras plataformas tácticas igualmente pueden tener un impacto estratégico en el futuro.

Además, la mejora en la agilidad de la gestión también se encuentra relacionado con la inteligencia artificial. Esto se aplica particularmente a los software y sensores que ayudarían a crear una mayor autonomía para los robots en lugares peligrosos. Es una de las fuerzas impulsoras detrás del uso de sistemas autónomos por parte de los militares. El ejército estadounidense tiene grandes esperanzas en la autonomía de las máquinas porque puede dar mayor margen de acción a las personas que comandan y luchan junto a los robots. Los desarrolladores de la inteligencia artificial en los Estados Unidos esperan pasar de poseer 50 soldados que actualmente apoyan a un solo drone, robot terrestre o acuático, a un paradigma en el que una sola persona será capaz de apoyar a 50 robots.

Pero la inteligencia artificial también puede llevarnos a serios problemas. La inteligencia artificial militar es capaz de potencialmente acelerar el combate hasta el punto en que las acciones de las máquinas superen las capacidades mentales y físicas de los responsables de la toma de decisiones en los puestos de mando que libraran esta guerra del futuro. Por lo tanto, la tecnología superará a la estrategia, y es muy probable que los errores humanos y los de las máquinas terminen por combinarse y afectarse mutuamente, con consecuencias bastante impredecibles e indeseadas.

Un estudio de la Corporación RAND sobre cómo las máquinas inteligentes afectan a la disuasión en medio de una confrontación militar destaca en sus páginas los serios problemas que pueden surgir si se usa la inteligencia artificial en un escenario de guerra (7). A partir de los resultados obtenidos por medio del desarrollo de juegos militares se logró demostrar que las acciones llevadas a cabo por una de las partes, donde ambos jugadores humanos interpretaron los acontecimientos como una reducción de la tensión en medio de la confrontación fueron, por el contrario, interpretados por la inteligencia artificial como indicativos de una creciente amenaza por parte del rival. Cuando un jugador humano estaba retirando sus fuerzas para reducir la escalada del conflicto, las máquinas lo percibían con mayor frecuencia como una ventaja táctica que hacía para consolidar sus posiciones. Y cuando el jugador humano hacia avanzar sus fuerzas hacia adelante como una demostración clara (pero no hostil) de determinación, las máquinas tendían a percibir esto como una amenaza inminente y tomaban una decisión hostil. El informe señaló que los seres humanos tendrán que enfrentarse no solo a la confusión que genera saber qué piensa el enemigo, sino también aprender a interpretar como la inteligencia artificial piensa al enemigo. Además, los jugadores humanos tuvieron que lidiar con cómo su propia inteligencia artificial podía malinterpretar las intenciones del enemigo humano, tanto las amistosas como las hostiles.

En otras palabras, las ideas que planteó en su momento Karel Čapek sobre los problemas generados por los robots siguen siendo muy relevantes a día de hoy: es imposible predecir el comportamiento de la inteligencia artificial. Y si los robots «inteligentes» terminan por tener aplicaciones militares eso significa que también pueden volverse peligrosos para sus mismos propietarios. En los Estados Unidos incluso ha estallado una polémica que enfrenta a muchos escépticos contra los usos militares de la IA en el combate, los militares escépticos ante estas nuevas tecnologías pertenecen al campo de los tradicionalistas (8) que creen que tales innovaciones creadas por los utopistas de Silicon Valley serán perjudiciales para el futuro del Estado norteamericano.

Notas:

1. https://www.defense.gov/Explore/News/Article/Article/2471165/dods-autonomous-vessel-sails-through-transit-test-participates-in-exercise-dawn/

2. https://nationalinterest.org/blog/reboot/underwater-suicide-drones-could-kill-chinese-submarines-176800

3. https://www.popsci.com/great-underwater-wall-robots-chinese-exhibit-shows-off-sea-drones/

4. https://breakingdefense.com/2021/01/uncle-sam-needs-ai-asap-dod-artificial-intelligence-chief/

5. https://dodcio.defense.gov/About-DoD-CIO/Organization/JAIC/

6. https://www.foreignaffairs.com/reviews/review-essay/2018-11-16/beyond-ai-arms-race?cid=soc-tw

7. https://www.rand.org/pubs/research_reports/RR4229.html

8. https://warontherocks.com/2021/01/the-faultline-between-futurists-and-traditionalists-in-national-security/

Fuente: https://www.geopolitica.ru/article/ot-rossumskih-robotov-do-iskusstvennogo-intellekta